本节课内容:

介绍单变量线性回归的Hypothesis公式、参数、代价函数,通过梯度下降法计算最优参数值,得到最终的Hypothesis公式,进行预测

单变量线性回归

代价函数(Cost Function):平方误差函数(最常用)

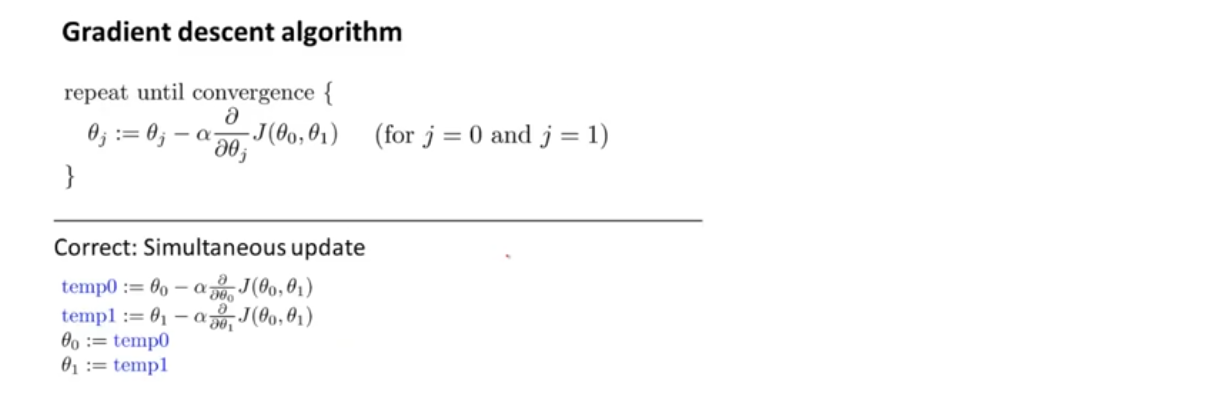

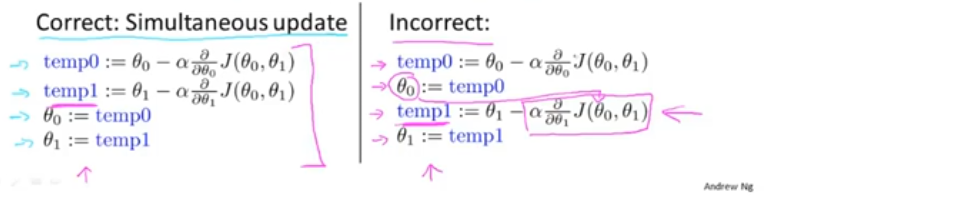

梯度下降

广泛用于机器学习的众多领域

α称为学习速率,控制以多大的幅度更新参数:

当α很小时,梯度下降很慢

当α很大时,梯度下降可能越过最低点,可能无法收敛,甚至会发散

注意:θ_0 和θ_1 必须同步更新

在梯度下降法中,当我们接近局部最低点时,梯度下降会自动采取更小的幅度,因为局部最低点的导数为0,当接近局部最低点时,导数值会自动变得越来越小

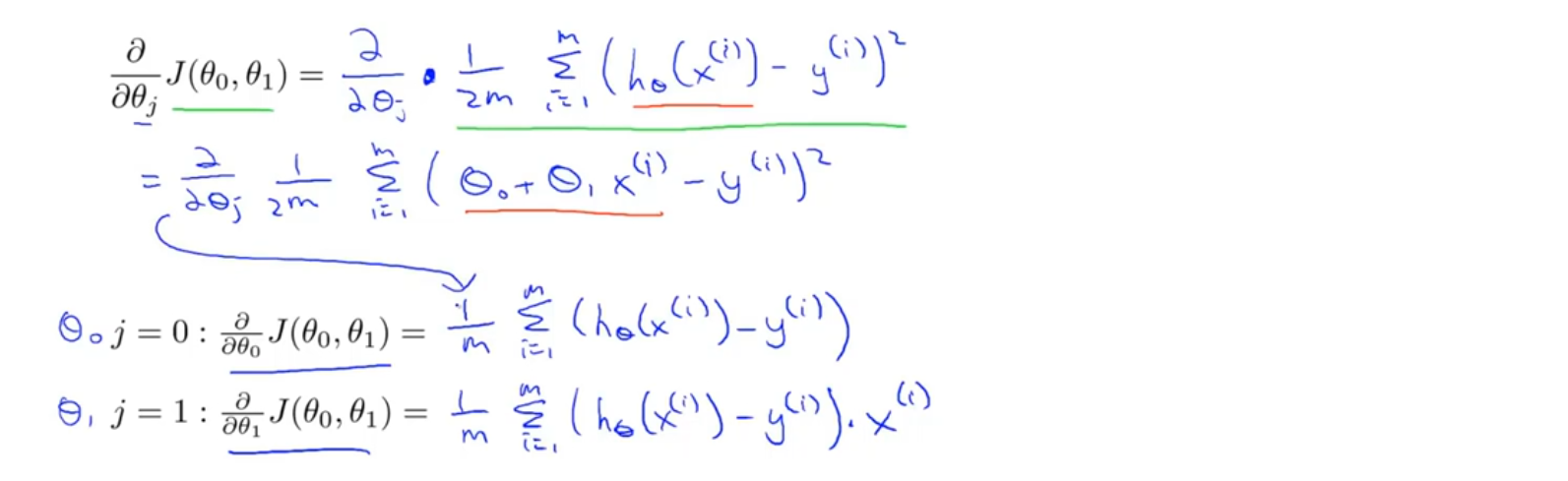

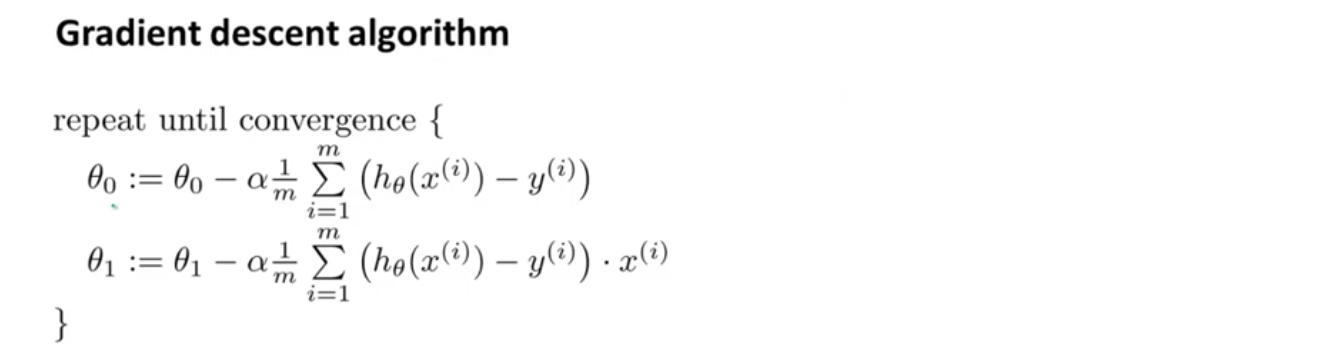

线性回归的梯度下降

“Batch” Gradient Descent:每一步的梯度下降的计算中都涉及到训练样本中的全部数据

课程资料

课程原版PPT-Linear regression with one variable

练习内容和相关说明

相关数据1,相关数据2